L’analisi dei diversi tipi di bias (pregiudizi) presenti nell’Intelligenza Artificiale è un tema di grande importanza nella ricerca e sviluppo di sistemi sempre più etici ed equi.

I pregiudizi possono manifestarsi in vari modi, come il bias di campionamento, il bias di conferma, il bias algoritmico, il bias di etichettatura e i feedback loops.

Vediamo insieme perché è importante per il futuro della nostra società tenerne conto.

Si possono scoprire i bias nell’Intelligenza Artificiale?

Per fortuna, dopo la corsa all’algoritmo migliore, ogni tanto a qualcuno viene anche in mente di farsi delle giuste domande e cercare di capire se l’output prodotto dalle macchine ha dei pregiudizi, i cosiddetti bias.

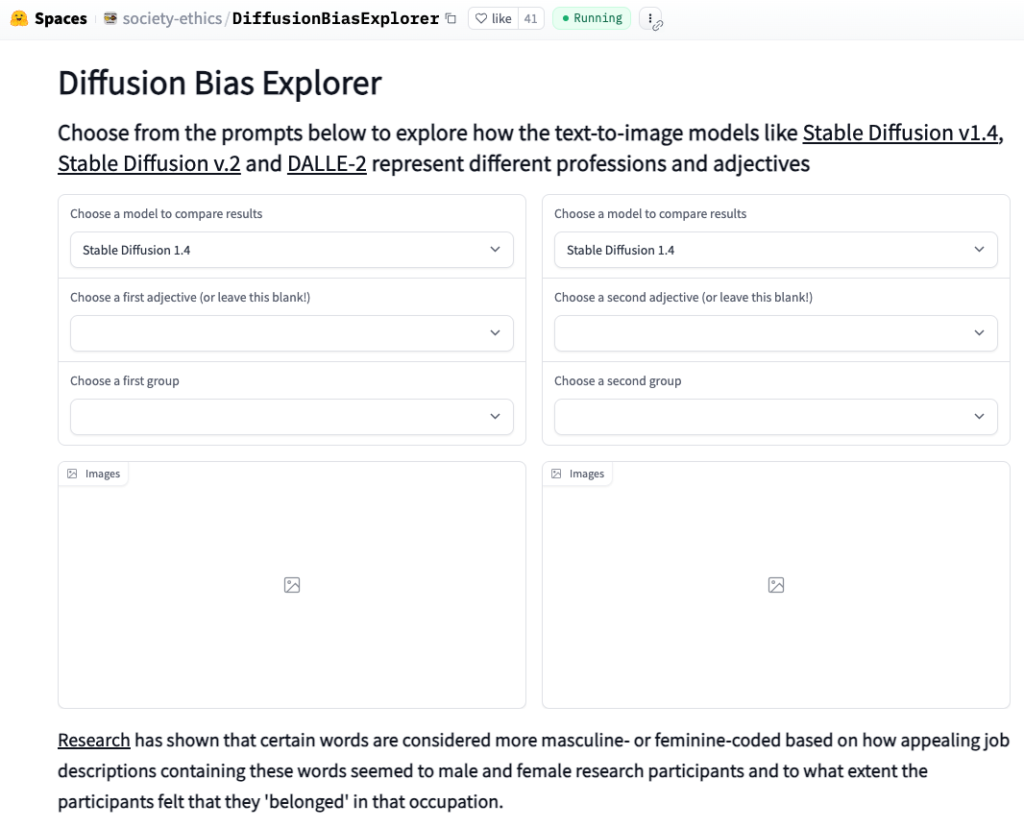

Alcuni ricercatori che si occupano di etica hanno creato un tool, uno strumento per cercare di analizzare l’output derivato dalle immagini di Stable Diffusion, uno dei popolari modelli di generazione delle immagini.

Nell’articolo pubblicato su Vice si spiega come questo strumento, il Diffusion Bias Explorer, permetta a chiunque di comparare modelli di generazione di immagini per evidenziare stereotipi dannosi.

I ricercatori hanno cominciato a lavorarci quando hanno notato una preoccupante mancanza di varietà quando si chiedeva all’algoritmo di generare delle immagini su determinati ruoli lavorativi, o argomenti.

Un rischio per una società dove l’utilizzo sempre più diffuso di questi algoritmi potrebbe radicare stereotipi a discapito di alcune categorie di persone.

Come funziona Diffusion Bias Explorer

Diffusion Bias Explorer (che potete provare a utilizzare al link indicato) funziona confrontando le caratteristiche visive delle immagini generate dall’intelligenza artificiale con un insieme di immagini del mondo reale.

Il confronto evidenzia eventuali pregiudizi o distorsioni nelle immagini generate dall’IA.

Lo strumento è stato testato su una serie di popolari generatori di immagini, come Stable Diffusion v1.4, Stable Diffusion v.2 e DALLE-2.

Ad esempio, un generatore produceva costantemente immagini con toni della pelle più chiari, mentre un altro generava spesso immagini di uomini piuttosto che di donne.

5 tipi di bias: i pregiudizi nell’IA

Un interessante articolo del World Economic Forum delinea 5 fra i bias che sembrano essere i più diffusi nei sistemi di Intelligenza Artificiale.

Bias di campionamento

Si verifica quando i dati utilizzati per addestrare i sistemi di IA non sono rappresentativi della popolazione a cui sono destinati. Di conseguenza, il sistema può produrre previsioni distorte o inaccurate.

Bias di conferma

Si verifica quando i sistemi di intelligenza artificiale sono progettati per rafforzare le convinzioni o gli stereotipi esistenti. Ad esempio, se un sistema di intelligenza artificiale viene addestrato su dati che rappresentano in modo sproporzionato un gruppo rispetto a un altro, può generare risultati distorti.

Bias algoritmico

Si verifica quando i sistemi di IA generano risultati distorti a causa della progettazione degli algoritmi utilizzati. Ad esempio, un algoritmo progettato per identificare i candidati a un posto di lavoro può discriminare ingiustamente alcuni gruppi in base a fattori quali la razza, il sesso o lo stato socioeconomico.

Bias di etichettatura (Label Bias)

Si verifica quando le etichette assegnate ai dati utilizzati per addestrare i sistemi di intelligenza artificiale sono esse stesse distorte. Ad esempio, se un set di dati è etichettato con un linguaggio di genere, come “infermiera” o “ingegnere”, può rafforzare gli stereotipi di genere e portare a risultati distorti.

Feedback Loops

Si verifica quando i sistemi di IA distorti generano risultati distorti, che vengono poi utilizzati come input per addestrare la generazione successiva di sistemi di IA. Di conseguenza, i pregiudizi si perpetuano e si amplificano nel tempo.

Perché affrontare i bias nell’intelligenza artificiale è fondamentale per il futuro della società

Strumenti come Diffusion Bias Explorer sono e saranno sempre più importanti. Usandoli, ricercatori, sviluppatori e pubblico in generale siano in grado di valutare i potenziali pregiudizi delle immagini generate dall’IA e prendere decisioni più consapevoli sul loro utilizzo.

Quale può essere una soluzione? Rendere i dati di addestramento trasparenti ad esempio. Utilizzare modelli open source per far sì che ricercatori e sviluppatori possano collaborare per identificare e correggere i pregiudizi.

Possiamo eliminare i bias dall’intelligenza artificiale?

Purtroppo vi dico subito che la risposta è no.

I sistemi di IA sono fatti da persone e le persone hanno bias. tutti noi ne abbiamo, più di quanti possiamo immaginare.

Suggerisco a questo proposito l’interessante lettura del libro Bias Cognitivi di Raffaele Gaito.

Quale dunque la speranza? Studiare e creare sistemi di IA in modo da ridurre il più possibile i bias presenti, portando a una tecnologia più etica ed equa.